新闻中心

2016年7月3日,政府管理学院信息管理与信息系统专业小学期专题讲座第四场在主楼A509顺利举行。此次讲座邀请到中国科学院大学经济管理学院岗位教授、中国科学院文献情报中心科技信息政策研究咨询与服务中心执行副主任顾立平老师,讲座题目是“基于Hadoop的大数据分析”。

顾立平老师长期从事为国家、中科院、图书情报出版界提供政策性建议的工作,已出版多部学术著作,包括:《型人导论》、《前瞻导论》、《数字图书馆发展》、《开放获取与信息服务》、《科学数据开放获取的政策性研究》。其中《型人导论》曾在学术界引起轰动,受多位专家称赞。

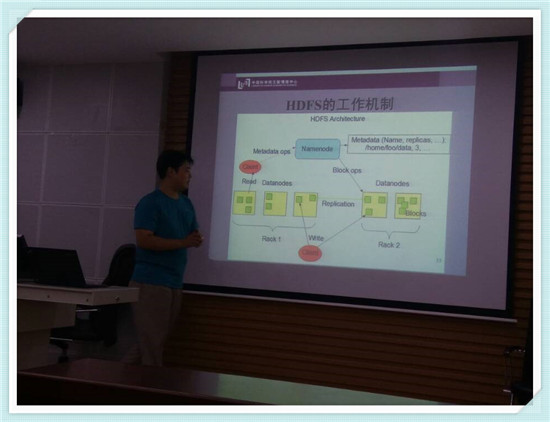

在此次讲座中,顾立平老师根据信息管理专业的特点,从海量数据的分析需求和信息系统的重构挑战、大数据分析技术的解决方案、Hadoop简介、HDFS简介、MapReduce简介、搭建实验平台等角度,为大家介绍大数据时代我们可以采取什么方式去处理海量数据。

顾立平老师首先从背景和需求两方面为大家介绍了究竟什么是大数据:即随着计算机技术的告诉发展,自然出现的一种规模大到在获取、存储、管理、分析等方面大大超出了传统数据库软件工具能力范围的数据集合,而如何解决这种超大规模的数据就是大数据领域的学者们主要研究的问题。为了方便大家理解,顾老师还用mysql数据库来举例说明mysql在处理海量数据时存在的问题——即面对大量的数据,一般数据库会受制于计算机硬件水平而出现卡顿,死机的情况,但是单方面提高计算机硬件水平成本又非常高而且在面对海量的数据时,再强大的机器往往也显得力不从心,而这就是问题的关键所在。而我们知道,问题即是需求,简单来讲这便是大数据这一提法存在的意义。在顾老师通俗易懂的解释下,以往总是显得高大上的大数据变得不再那么神秘,大数据就在我们身边。

紧接着,顾立平老师重点介绍了Hadoop。作为一种分布式系统基础架构,Hadoop以若干计算机为节点,由中央系统对每一个节点进行协调分配,并行处理这些信息。Hadoop构架有很多优点,如高可靠性、高扩展性、高容错性以及低成本。整个Hadoop生态系统最核心的设计有以下三点:Hbase、HDFS和MapReduce。

Hbase主要是对数据进行key-value存储。顾老师用mysql为例为我们说明:由于数据库中的每一条数据都包含了很多无关信息,而key-value存储既是将这些数据进行筛选,提取出重要信息进行存储,这样一来在系统进行数据处理时,效率会大大提高。而对外部客户机而言,HDFS就像一个传统的分级文件系统,可以在整个系统中进行创建、删除、移动或重命名文件,其中有两大重要的模块:Namenode和datanode,对这两个部分的解释,顾老师认为,Namenode记录了一共有哪些数据,而Datanode则记录了这些数据在系统中的路径。而MapReduce是一种编程模型,用于大规模数据集的并行运算,其核心思想是“分而治之”,即将大量的数据分为若干模块,分别进行处理。因此,有着这些架构特点的Hadoop也就成为了目前处理大数据的一种较为可靠使用的方式。

此次讲座是本次小学期的最后一次讲座。参与此次讲座学习的同学一致认为,这类讲座能给尚在科研道路上探索的信管专业的同学,提供一个开阔的研究视野,进而帮助大家增强了学术素养。